Лаборатория Google DeepMind разработала новый подход к обучению алгоритмов искусственного интеллекта, который позволяет сделать процесс в десять раз эффективнее.

Он получил название IMPALA, а его работа описывается в статье на сайте ArXiv.org. Кроме того, DeepMind также выпустила набор новых игровых уровней для виртуальной среды DeepMind Lab, о чем рассказывается в блоге подразделения.

Большинство алгоритмов искусственного интеллекта, предназначенных для анализа и освоения различных игр, используют обучение с подкреплением. В процессе тренировки программа получает отклик от среды — например очки за успешное прохождение уровня или штрафные баллы за ошибки — и благодаря этому улучшает свою работу. Однако, как правило, алгоритм учится выполнять конкретную задачу и, попадая в новые условия, он не может применить ранее полученные навыки.

Разработчики из лаборатории DeepMind предложили новый алгоритм машинного обучения под названием Importance Weighted Actor-Learner Architectures (IMPALA). Он позволяет отдельным частям обучаться выполнению сразу нескольких задач, а потом обмениваться знаниями между собой. Во многом система была вдохновлена архитектурой системы A3C, в которой отдельные агенты исследуют среду, затем процесс приостанавливается и они обмениваются знаниями с центральным компонентом, «учеником». У IMPALA агентов может быть больше, и процесс обучения происходит несколько по-другому. В ней агенты посылают информацию сразу двум «ученикам», которые после этого еще и обмениваются данными между собой (хотя ученик может быть и один). Кроме того, если в A3C агенты вычисляют градиент функции потерь (фактически, это несоответствие предсказанных и полученных значений параметров), и отправляют его к центральному ядру, то в системе IMPALA этой задачей занимаются «ученики».

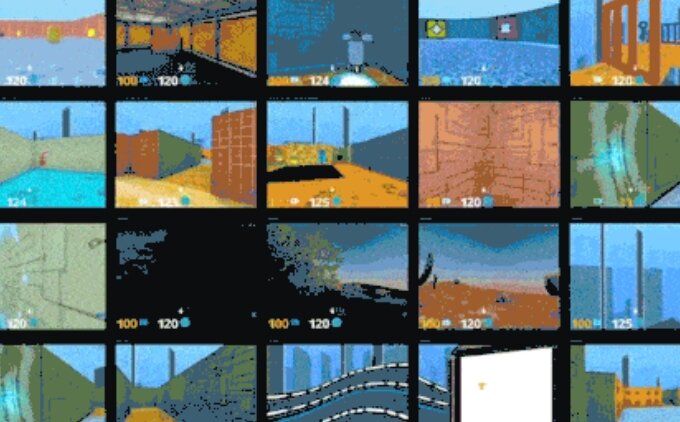

Алгоритм лаборатории DeepMind обучался на недавно выпущенном датасете DMLab-30 — программа тренировалась на 57 играх компании Atari. Как показало тестирование, при наличии достаточного числа процессоров IMPALA может обрабатывать примерно 250 000 кадров в секунду или 21 миллиардов кадров в день. Как пишет The Next Web, это абсолютный рекорд для такого рода задач. Сравнение с A3C показало, что система проходила игры в 10 раз эффективнее и в конце игры имела в два раза больше очков. Кроме того, разработчики отмечают, что новая программа превосходит и все предыдущие системы ИИ, и человека.

Для сравнения, на первом видео показано, как проходит игры Atari человек:

А здесь можно увидеть, как справляется с этой задачей IMPALA:

В будущем подобные алгоритмы ИИ могут быть использованы и в робототехнике. Оптимизация систем машинного обучения позволит роботам быстрее адаптироваться к окружающей среде и работать эффективнее.

Благодаря обучению с подкреплением алгоритмы сегодня уже освоили паркур, игру StarCraft II, виртуальный футбол и трехмерные лабиринты. Кроме того, недавно систему научили ИИ определять вес и количество объектов в виртуальном мире.

Источник: N+1

Подписывайтесь на канал «Хвилі» в Telegram, страницу «Хвилі» в Facebook.